Jak nakręcić profesjonalny film HDR

Co to jest HDR?

HDR, czyli High Dynamic Range, to przede wszystkim zwiększenie zakresu jasności wyświetlanego przez monitor lub telewizor. Do niedawna większość telewizorów i monitorów nie mogła wyświetlać bardzo dużego zakresu jasności — zwykle było to około 6 EV. Nowe technologie wyświetlania, takie jak OLED (Organic Light Emitting Diode) i postęp w technologii podświetlenia LCD umożliwiły produkcję ekranów, które mogą wyświetlać 10 lub więcej EV rozpiętości tonalnej. Ekrany te są nie tylko jaśniejsze, ale mają również lepszy kontrast w ciemniejszych partiach obrazu.

Powyższe obrazy są symulacją różnicy między obrazem SDR (po lewej) a obrazem HDR (po prawej), gdy korzysta się z telewizora lub monitora HDR. Większa rozpiętość tonalna i szerszy zakres kolorów wyświetlacza HDR pozwoli na większy zakres podświetlenia i większy zakres kolorów do wyświetlenia.

Aby obejrzeć niniejsze wideo w najwyższej jakości 4K HDR, przejdź tutaj. Jeśli odtwarzacz YouTube wykryje urządzenie spełniające wymagania, zostanie wyświetlona czerwona ikona opcji HDR. HDR jest teraz standardem w większości flagowych telefonów komórkowych i telewizorów, a liczba urządzeń obsługujących tę technologię stale rośnie.

Jak kręcić w technologii HDR?

Wielu z nas od lat nagrywa przy użyciu formatów gotowych na HDR, takich jak Log lub Raw. Aby filmować treści odpowiednie do technologii HDR, należy korzystać z formatu o bardzo dużej rozpiętości tonalnej. Kiedy filmowałem wulkan Fagradalsfjall na Islandii, zastosowałem krzywą S-Log3 firmy Sony i technologię ProRes Raw, używając kamer Sony FX6 i FX3. Podczas filmowania przy użyciu S-Log3 lub RAW za pomocą tych kamer rejestruje się bardzo dużą rozpiętość tonalną, nawet ponad 14 EV. To więcej, niż obsługują najlepsze obecnie telewizory i monitory HDR. Ponadto te formaty pozwalają na zarządzanie obrazem w postprodukcji za pomocą procesu gradacji w celu tworzenia świetnie wyglądających treści HDR. Wiele kamer Sony ma również dedykowany tryb HDR i w tym trybie kamery używają funkcji gamma zwanej HLG. HLG to jedna z funkcji gamma wyświetlaczy stosowanych w telewizorach HDR, a treść sfilmowana za jej pomocą nie musi podlegać gradacji — kamerę opuszcza od razu w technologii HDR i na odpowiednim telewizorze będzie wyświetlana w dużej rozpiętości tonalnej.

Czy w przypadku korzystania z HDR konieczna jest inna ekspozycja?

Podczas filmowania w HDR nie ma potrzeby ustawiania ekspozycji w inny sposób niż w przypadku SDR (standardowej rozpiętości tonalnej). Myślę, że wiele osób sądzi, że w przypadku HDR konieczna jest jaśniejsza ekspozycja, ale zwykle tak nie jest. Należy pamiętać, że HDR oznacza większą rozpiętość tonalną. Chodzi o rejestrowany zakres, a nie tylko o jasność. Twarze, ludzie, rośliny, budynki nie powinny być jaśniejsze w HDR niż w SDR — powinny być takie same, więc jednakowa powinna być również ekspozycja. Telewizor HDR może jednak wyświetlać jasne elementy, np. odbicia od błyszczących powierzchni lub bardzo jasne niebo, a jednocześnie szczegóły i tekstury w głębokich cieniach, które zwykle giną na ekranie SDR. Kluczem jest więc prawidłowa ekspozycja tonów średnich, a wtedy jasne elementy i głębokie cienie znajdą się na odpowiednim poziomie.

Filmowanie wulkanu okazało się dość trudne, ponieważ ziemia była bardzo ciemna, prawie czarna, a płynąca lawa bardzo jasna. Niewiele było tonów średnich, które można by było wykorzystać do ustawienia ekspozycji, tak jak zazwyczaj. Skorzystałem zatem z wbudowanych w FX6 tabel LUT oraz tabeli s709, aby znaleźć równowagę wizualną między ciemną lawą zastygniętą a bardzo jasną płynną. Użyłem również monitora krzywych, aby zmierzyć poziomy nagrywania, co pomaga upewnić się, że ekspozycja nie jest zbyt ciemna lub zbyt jasna.

Pierwszy z poniższych kadrów przedstawia obraz S-Log3 zarejestrowany przez kamerę. Dwa kolejne symulują różnicę między klasą SDR (drugi) i HDR (trzeci) podczas oglądania na monitorze lub telewizorze SDR i HDR. Średni zakres obu obrazów wygląda nieco inaczej, ale obraz HDR ma większy zakres podświetlenia i w rezultacie na wyświetlaczu HDR podświetlenie obrazu HDR będzie jaśniejsze.

Jak dokonujesz gradacji pod kątem HDR?

Preferowaną przeze mnie metodą gradacji jest stosowanie oprogramowania, które wykorzystuje procedurę zarządzania kolorami. Umożliwia ona ustawienie formatu, w którym sfilmowano materiał, oraz formatu, w którym ma on zostać dostarczony. W wielu przypadkach oprogramowanie jest w stanie odczytać metadane pliku wideo, aby poznać format, w jakim go utworzono. Coraz częściej oprogramowanie wykrywa również rodzaj posiadanego wyświetlacza. Następnie może wykonać poprawną konwersję pliku z uwzględnieniem tego, jak obraz został sfilmowany, a jak będzie wyświetlany. Oczywiście, aby wyświetlić materiał w HDR, konieczny jest monitor lub telewizor HDR — dobrze wyglądających treści o dużej rozpiętości tonalnej nie da się przygotować na ekranie SDR.

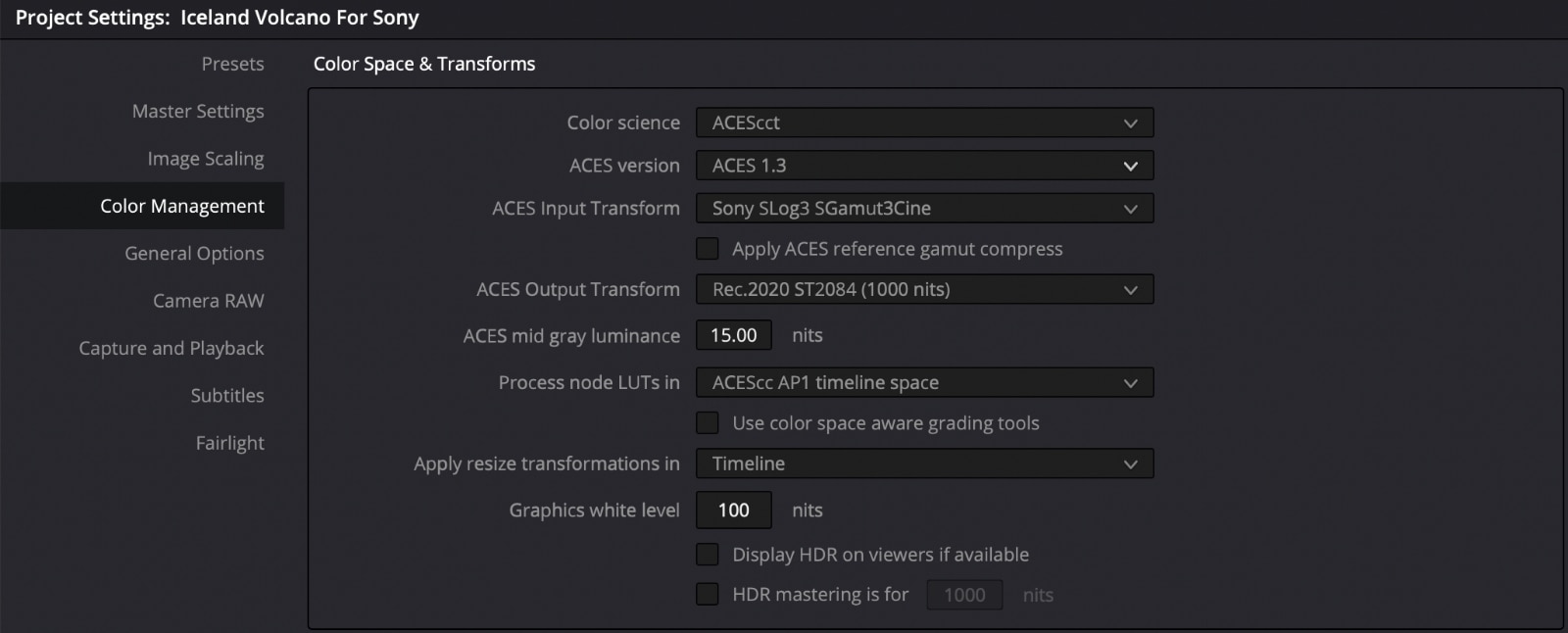

Poniższy obraz: ustawienia zarządzania kolorami w DaVinci Resolve dla procedury ACES S-Log3 do HDR.

Jak ważne są procedury zarządzania kolorami?

Ten rodzaj procedur będzie miał coraz większe znaczenie w nadchodzących latach wraz ze wzrostem potrzeby dostarczania treści zarówno w SDR, jak i HDR. Używam DaVinci Resolve do gradacji kolorów i dołączonych procedur zarządzania kolorami ACES. ACES to Academy of Motion Pictures Color Encoding System. System ten został zaprojektowany tak, aby zapewnić jednolitą procedurę zarządzania kolorami, która może być uwzględniona w wielu różnych aplikacjach do edycji i gradacji. W ramach Resolve i ACES, korzystając z preferencji zarządzania kolorami, wprowadzam do ACES informacje, że filmowałem, korzystając z S-Log3 i że chcę dostarczyć treści w HDR, a oprogramowanie wykonuje wszystkie niezbędne konwersje pomiędzy tym, jak nagranie zostało nakręcone, a tym, jak będzie wyświetlane w HDR. Nie ma potrzeby korzystania z tablic LUT czy innych narzędzi — oprogramowanie wykonuje całą pracę za użytkownika. Następnie wykonuję gradację materiału, aby go ostatecznie dopracować. Jeśli będę potrzebował wersji SDR, wystarczy, że ustawię Resolve/ACES na SDR/Rec709 zamiast HDR, a wtedy zamiast materiału w HDR otrzymam go w SDR. Narzędzia do zarządzania kolorami są teraz obecne w większości lepszych systemów do edycji i gradacji kolorów, w tym Adobe Premiere i Final Cut Pro.

Jak wygląda prezentowanie treści w HDR?

Jest to kwestia, w której obserwujemy obecnie wiele zmian. Cztery czy pięć lat temu wyświetlacze HDR były rzadkością. Dziś pojawiają się wszędzie. Większość telefonów klasy premium ma teraz ekrany HDR. Telewizory HDR są obecnie powszechne i niewiele droższe niż telewizory SDR o podobnej jakości. Komputery też nadrabiają zaległości, a wyświetlacze HDR pojawiają się w coraz większej liczbie laptopów. Ale nie każdy ma ekran HDR, a jeśli wyświetlasz treść HDR na ekranie SDR bez jej dostosowania, wygląda to nie najlepiej. Na szczęście platformy takie jak YouTube mają już możliwość konwersji filmu przesłanego w HDR do SDR, dzięki czemu gdy widz ogląda film na wyświetlaczu SDR, jest on odtwarzany w SDR. Osoby mające urządzenie z wyświetlaczem HDR zobaczą treść w HDR. Jednak aby było to możliwe, YouTube i podobne platformy muszą wiedzieć, że filmy są w technologii HDR. Do tego konieczne są metadane.

Metadane HDR

Metadane to „dane dotyczące danych”. Podczas kodowania pliku wideo dodawanych jest ich wiele. Jedną z istotnych zalet korzystania z zarządzania kolorami jest to, że w ramach tej procedury podczas kodowania pliku oprogramowanie zwykle dodaje poprawne znaczniki metadanych, które oznaczą plik jako HDR. Co więcej, metadane określą również konkretny typ HDR wraz z informacjami o docelowej krzywej gamma i przestrzeni kolorów. Gdy używam DaVinci Resolve do eksportowania pliku z ACES lub własnego zarządzania kolorami programu Resolve, koder domyślnie dodaje znaczniki metadanych, które pasują do docelowych ustawień wyjściowych projektu. W ten sposób, po przesłaniu gotowego klipu do YouTube, platforma wie, że plik jest w HDR i wie, na jakim wyświetlaczu go oglądałem podczas gradacji. Dzięki tym informacjom YouTube może przekonwertować plik na inne standardy oglądania — zatem niezależnie od tego, czy widz ma wyświetlacz HDR, czy SDR, zawsze będzie widział prawidłowy obraz, nawet jeśli przesłałem tylko jeden plik HDR.

Wybór kodeka pod kątem HDR

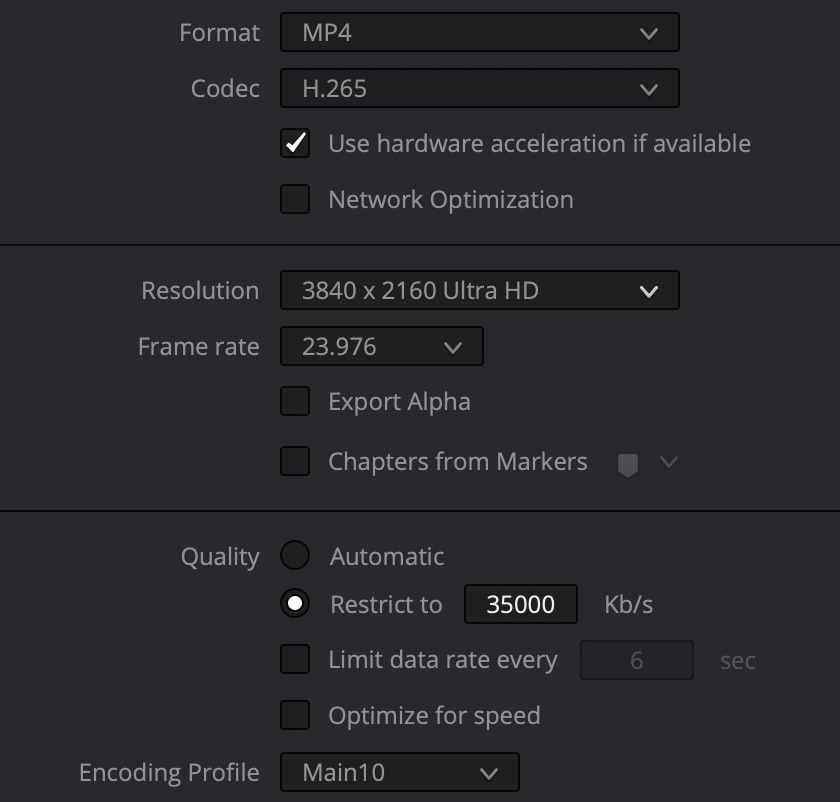

Oprócz metadanych niezbędny jest również kodek bardzo wysokiej jakości, najlepiej 10-bitowy. Wynika to z tego, że większa rozpiętość tonalna i zwiększony kontrast obrazu HDR mogą skutkować bardziej widocznymi problemami z kompresją. Jednym z najczęściej używanych kodeków do dystrybucji wideo HDR jest H.265. H.265 to 10-bitowy kodek, który wykorzystuje bardzo wydajną kompresję, aby zachować mały rozmiar pliku. Większość telewizorów HDR może bezpośrednio odtwarzać wideo zakodowane za pomocą H.265 z pamięci USB podłączonej do telewizora. Kodek H.265 obsługują również YouTube, Vimeo itp., a jakość pozostaje bardzo wysoka nawet w przypadku niższej szybkości transmisji bitów. Ja koduję pliki 4K H.265 z prędkością 35 Mb/s, ponieważ jest to najwyższa szybkość transmisji H.265 obsługiwana przez większość telewizorów HDR.

Na obrazie znajdziecie ustawienie kodowania, którego użyłem w nagraniu HDR wulkanu.

HDR we współczesnych zastosowaniach

Technologia HDR jest już powszechna i nigdzie się nie wybiera. W przyszłości będzie normą, a SDR wyjdzie z użycia. Chociaż nie stanie się to z dnia na dzień, potrzeba dostarczania treści w HDR będzie stale rosła, ponieważ technologię tę obsługuje coraz więcej urządzeń, a widzowie cenią zapewnianą przez nią wyższą jakość treści. Jednocześnie coraz łatwiej jest kręcić i dostarczać świetnie wyglądające treści HDR. Twórcy filmów muszą nauczyć się nowych rzeczy, takich jak dbanie o prawidłowość metadanych, ale gdy już się tego nauczą, dostarczanie treści w HDR będzie równie proste, co w przypadku SDR. W nagraniu w HDR wulkan Fagrasdalsfjall wygląda znacznie bardziej realistycznie niż w SDR i wiem, że chciałbym, aby ludzie mieli możliwość widzieć go właśnie takim.

Jeśli chcesz dowiedzieć się więcej o tej sesji, zachęcam do przeczytania mojego artykułu Cztery pory roku w jednym dniu i rozpalony do czerwoności wulkan.